Скачать с ютуб Scalable ML acceleration with ONNX Runtime в хорошем качестве

Из-за периодической блокировки нашего сайта РКН сервисами, просим воспользоваться резервным адресом:

Загрузить через dTub.ru Загрузить через ClipSaver.ruСкачать бесплатно Scalable ML acceleration with ONNX Runtime в качестве 4к (2к / 1080p)

У нас вы можете посмотреть бесплатно Scalable ML acceleration with ONNX Runtime или скачать в максимальном доступном качестве, которое было загружено на ютуб. Для скачивания выберите вариант из формы ниже:

Загрузить музыку / рингтон Scalable ML acceleration with ONNX Runtime в формате MP3:

Роботам не доступно скачивание файлов. Если вы считаете что это ошибочное сообщение - попробуйте зайти на сайт через браузер google chrome или mozilla firefox. Если сообщение не исчезает - напишите о проблеме в обратную связь. Спасибо.

Если кнопки скачивания не

загрузились

НАЖМИТЕ ЗДЕСЬ или обновите страницу

Если возникают проблемы со скачиванием, пожалуйста напишите в поддержку по адресу внизу

страницы.

Спасибо за использование сервиса savevideohd.ru

Scalable ML acceleration with ONNX Runtime

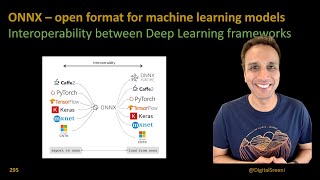

Technical session delivered by Manash Goswami, Principal Program Manager at Microsoft. ONNX Runtime is an open source inference engine for ONNX Models. ONNX Runtime Execution Providers (EPs) enables the execution of any ONNX model using a single set of inference APIs that provide access to the best hardware acceleration available. In simple terms, developers no longer need to worry about the nuances of hardware specific custom libraries to accelerate their machine learning models. This technical session demonstrates that by enabling the same code to run on different hardware platforms using their respective AI acceleration libraries for optimized execution of the ONNX model. Stay connected with Arm: Website: http://arm.com/ Twitter: / arm Facebook: / arm LinkedIn: / arm Instagram: / arm