Скачать с ютуб Visualize the Transformers Multi-Head Attention in Action в хорошем качестве

Из-за периодической блокировки нашего сайта РКН сервисами, просим воспользоваться резервным адресом:

Загрузить через dTub.ru Загрузить через ClipSaver.ruСкачать бесплатно Visualize the Transformers Multi-Head Attention in Action в качестве 4к (2к / 1080p)

У нас вы можете посмотреть бесплатно Visualize the Transformers Multi-Head Attention in Action или скачать в максимальном доступном качестве, которое было загружено на ютуб. Для скачивания выберите вариант из формы ниже:

Загрузить музыку / рингтон Visualize the Transformers Multi-Head Attention in Action в формате MP3:

Роботам не доступно скачивание файлов. Если вы считаете что это ошибочное сообщение - попробуйте зайти на сайт через браузер google chrome или mozilla firefox. Если сообщение не исчезает - напишите о проблеме в обратную связь. Спасибо.

Если кнопки скачивания не

загрузились

НАЖМИТЕ ЗДЕСЬ или обновите страницу

Если возникают проблемы со скачиванием, пожалуйста напишите в поддержку по адресу внизу

страницы.

Спасибо за использование сервиса savevideohd.ru

Visualize the Transformers Multi-Head Attention in Action

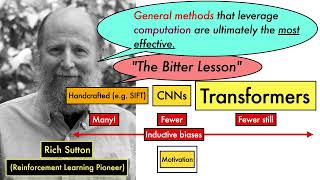

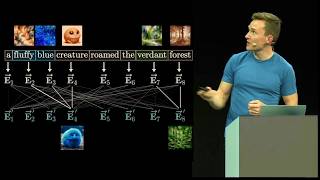

We depict how a single layer Multi-Head Attention Network applies mathematical projections over Question-Answer data, following the Encoder-Decoder architecture discussed in the paper "Attention is all you Need" https://browse.arxiv.org/pdf/1706.037... Attention Networks are used in modern AI technologies like BERT, GPTx, ChatGPT, etc. as it learns about relationships between different parts of the data that it encounters. The video provides conceptual depictions of what is happening 'under the hood' as abstract concepts in multi-dimensional space are manipulated during training and at inference time. Python / PyTorch implementation referred to in this video: https://github.com/learningcurveai/tr...

![Hopfield network: How are memories stored in neural networks? [Nobel Prize in Physics 2024] #SoME2](https://i.ytimg.com/vi/piF6D6CQxUw/mqdefault.jpg)